In einem englischsprachigen Post erkläre ich, wie man PostGIS und pgAdmin4 in Docker-Containern zum laufen bekommt:

https://www.riannek.de/2023/how-to-use-postgis-in-a-docker-container/

Blog

Rumänien

Reise durch ein abwechslungsreiches Land

Sechs Wochen hatten wir Zeit, um kreuz und quer durch dieses abwechslungsreiche Land zu Reisen. Rumänien hat viel zu Bieten, von Burgen und Kirchen über Berge und Höhlen bis zum Schwarzen Meer und dem Donaudelta. Hier trafen sehr unterschiedliche Kulturen nicht immer friedlich aufeinander und diese haben sehr vielfältige Spuren hinterlassen. Rumänien erscheint als das Land der zwei Geschwindigkeiten: während die Städte modern wirken, rollen auf den Dörfern noch immer Pferdekarren durch die Straßen und das Heu wird in mühsamer Arbeit zu (sehr hübschen!) Heuhaufen zusammengetragen.

Die meiste Zeit verbrachten wir in Transsylvanien (Siebenbürgen), das an drei Seiten vom Bogen der Karpaten und an der vierten Seite vom Apuseni-Gebirge umschlossen ist. Eine Besonderheit sind hier die vielen Kirchenburgen, die von den (vom ungarischen König zwecks Sicherung der Grenzregionen angesiedelten) Sachsen in fast jeder Siedlung errichtet worden waren und von denen jede ihren eigenen Charakter hat. Das Highlight ist für uns Viscri (Weißkirch), ein hübsches Dorf mit einer von Mauern und weißen Türmen umgebenen Kirche. Hier verbringen wir eine Nacht in einer Pension in einem der alten Häuser und schlafen in einer alten sächsischen Bettkiste, mit je einem Bett oben und darunter einem in einer Schublade ausziehbaren zweiten Bett. In Trappold (Apold) haben wir die Gelegenheit, auch den Dachstuhl einer Kirchenburg zu erkunden. Ebenfalls sehr schön waren Biertan und Prejmer.

Die berühmteste Burg ist natürlich Bran, oft als Dracular-Burg bezeichnet. Durch die Räume und den kleinen Hof quetscht sich eine endlose Ameisenstraße von Touristen. Viel beeindruckender ist jedoch die Burg Hunedoara.

Die bekanntesten Städte in Siebenbürgen sind Brasov (Kronstadt), Sighișoara (Schäßburg) und Sibiu (Hermannstadt). Sighișoara mit seinen vielen Türmen ist besonders pittoresk, aber hier drängen sich auch am meisten Touristen durch die Gassen. Sibiu, mit seinen drei großen Plätzen und mit guten Museen, gefällt uns am Besten.

Völlig anders sind die Holzkirchen weiter im Norden in Maramureș, die mich an norwegische Stabskirchen erinnern. Am besten gefallen mir die Kirchen in Șurdești und Plopiș, mit besonders hohen Türmen. Über einen Pass geht es auf die andere Seite der Karpaten in die Bukovina, wo es einige orthodoxe Klöster des damaligen Fürstentums Moldau gibt. Wir sehen drei, Moldovitei, Sucevita und Voronet. Die Kirchen sind nicht nur innen, sondern auch an den Außenwänden voller Fresken, und sie werden durch geschwungene Dächer bedeckt.

Wieder über die Karpaten fahren wir durch die Bicaz-Schlucht und spazieren um den Lacul Roşu. Dieser ist durch einen Bergsturz aufgestaut worden und es ragen noch immer die Baumstümpfe über die Wasseroberfläche. Allerdings sind hier viele Touristen.

Vom St.-Anna-See (einem Vulkansee) hatte ich mehr erwartet, die tollen Bilder im Netz sind wohl alle mit Drohnen aufgenommen. Einen Regentag nutzen wir im benachbarten Baile Balvanyos im Termalbad.

Wieder über die Karpaten besuchen wir die Schlammvulkane von Berca (Vulcanii noroiosi). Ich habe ja schon einige Schlammvulkane in Aserbaidschan und Indonesien gesehen, aber die rumänischen sind auch sehr schön. Vom Campingplatz aus erkunden wir sowohl Pâclele Mici (mit vielen kleinen Kegeln) als auch Pâclele Mari (ein sehr großer Fladen mit aktivem kleinem Kegel an der Spitze).

Das nächste Ziel war das Donaudelta. Von Murighiol (am Südrand und mit dem Auto erreichbar) starten wir zu einer vierstündigen Bootstour über den Donauarm, durch schmale Kanäle, über zahllose Seen und durch deren Schilfgürtel. Die Morgenstimmung ist wunderschön und es gibt jede Menge Pelikane, Eisvögel, Reiher und Adler zu sehen. Im Nachbarort Mahmudia nehmen wir die Fähre (3 mal pro Woche) den Donauarm abwärts nach Sfântu Gheorghe, das nahe der Mündung liegt und nur per Boot erreichbar ist. Hier gehen die Uhren langsamer … Ein langer Strand ist zu Fuß erreichbar und es gibt sehr guten Fisch zum Essen.

In Bukarest ist der Palast von Ceaușescu unser erstes Ziel, das mit seinem Prunk die Idee des Kommunismus wirklich ad absurdum führt. Die Stadt mit ihren heftigen Brüchen zwischen sozialistischer Architektur und Altbauten ist viel interessanter als erwartet.

Die kurvige Transfăgărășan-Passstraße, die von der Wallachei zurück nach Transsylvanien führt, wird von keinen Reisenden ausgelassen. Auf dem Weg dorthin lohnt ein Halt in Curtea de Argeș mit besonders schönen orthodoxen Kirchen. Bei der Fahrt über den Pass sehen wir gleich zwei Bärenfamilien. Die Tiere sind Touristen so gewöhnt, dass sie an der Straße betteln. Von oben wandere ich zum höchsten Berg Rumäniens.

Ein weiteres Gebiet mit alpinem Charakter befindet sich weiter westlich: Im Rezetat gibt es jede Menge Bergseen zwischen schroffen Gipfeln. Wir holpern mit dem Auto über eine lange Schotterpiste zur Hütte Pelegii und steigen von hier zum Bucura-See auf, wo wir unser Zelt aufschlagen. Abends drehen wir eine Runde zum höchsten See, Lacul Taul Portii, und am nächsten Morgen zum höchsten Gipfel der Gegend, Vârful Peleaga (2509 m).

Vârful Moldoveanu

Wanderung vom Balea-See an der Transfăgărăşan-Straße auf den höchsten Berg Rumäniens

Der höchste Berg Rumäniens befindet sich in den Făgăraș-Bergen in den Südkarpaten, die im Vergleich zum Großteil der eher hügeligen Karpaten einen alpinen Charakter aufweisen. Eine schöne Route zum Gipfel beginnt am Balea-See am höchsten Punkt der Transfăgărăşan-Straße und folgt wunderschön dem Hauptkamm der Berge, der seine Umgebung deutlich überragt. Meist wird für Hin- und Rückweg je ein Tag geplant, aber ausdauernde Wanderer können es auch gut an einem (langen) Tag schaffen.

Ich steige in der Dämmerung im Licht der Stirnlampe zum ersten Sattel auf und bin bei Sonnenaufgang am nächsten kleinen See, Capra. Auf dem weiteren Weg werde ich durch wunderschönes Morgenlicht und Einsamkeit belohnt. Auf der ersten Hälfte der Strecke geht es ordentlich auf und ab, während die zweite Hälfte bis kurz unterhalb des Vorgipfels ohne wenig Aufwand den Höhenlinien folgt. Dabei geht es über schmale grasige Grate, mit schönen Blicken in Kare und Täler. Kurz bevor ich den Gipfel erreiche, schwappen leider die Wolken über den Kamm. Auf dem Rückweg hängt eine undurchdringliche weiße Suppe auf der Nordseite des Kamms und Nebelschwaden verleihen den Bergen ein völlig anderes Aussehen. Am späten Nachmittag komme ich wieder an den See und bin dort von den Menschenmassen etwas überfordert.

Auf dem Padiş-Plateau im Apuseni-Gebirge

Kurze Wanderungen zu Höhlen und Ponoren (Rumänien)

Das Padiş-Plateau ist ein verkarstetes Kalksteinplateau, von dem es keinen überirdischen Abfluss von Wasser gibt. Es befindet sich auf der Westseite des Apuseni-Gebirges, das wiederum die westliche Grenze von Transsylvanien bildet.

Das Gebiet steht unter Naturschutz, aber im Zentrum gibt es einen über eine holprige Piste erreichbaren kostenlosen „Campingplatz“. Hier wimmelt es von Zelten und Vans, es gibt mehrere Imbissbuden, aber leider mangelt es an Toiletten (mit entsprechenden Auswirkungen auf den benachbarten Wald). Jedenfalls ist dies ein idealer Ausgangspunkt für ein paar kurze Wanderungen.

Etwa 1,5 km südwestlich befindet sich ein sehr hübsches, rundum von Hügeln umsäumtes Tal (ein Polje). Das Flüsschen kommt aus einem kleinen Höhlenloch, schlängelt sich malerisch über Wiesen und verschwindet wieder in Ponoren.

Etwa 1,5 km südlich des Camps führt ein kurzer Rundweg durch die Cetățile Ponorului („Zitadelle der Ponore“). Es handelt sich um eine Reihe von großen Dolinen mit hohen Felswänden und einem beeindruckenden Höhlentor, in dessen Inneren Wasser aus einem Felsloch schießt und in kleinen Wasserfällen im Höhlenschlund verschwindet.

Rund 4 km nördlich befindet sich die Höhle Cetătile Rădesei. Mit Stirnlampe ausgerüstet kann man dem unterirdischen Bach folgen, hin und wieder mit leichter Kraxelei. Ein Pfad führt an der anderen Seite aus der Schlucht hinaus und zum Ausgangspunkt zurück.

Lithium: Produktion und Verwendung

Interaktiver Plot mit Produktion und Nutzung von Lithium

Ohne Lithium keine leichten Akkus mit hoher Kapazität. Mit zunehmender Elektromobilität wird dieses Metall immer wichtiger. Der interaktive Plot (Daten von 2022) zeigt, welche Länder wie viel davon produzieren (meist aus Salaren und Salzseen, siehe Die Welt der Rohstoffe) und wie es genutzt wird. Die Daten stammen vom USGS (2023). Den fehlenden Wert für die USA habe ich aus den anderen Daten geschätzt.

Dies ist mein erstes Sankey-Diagramm, erstellt mit plotly und python. Um den Plot in WordPress darzustellen, habe ich die HTML-Datei des Plots mit FTP hochgeladen. Nun habe ich das HTML-Tag für einen iframe direkt in den WordPress-Editor (klassischer Editor im Textmodus) eingefügt.

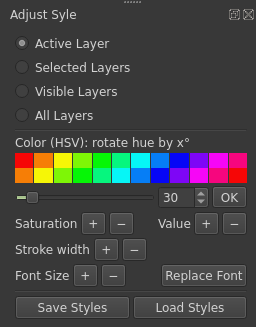

QGIS-Plugin für schnelle Anpassung des Kartenstils

Symbologie und Schriftgröße einer QGIS-Karte mit wenigen Klicks ändern, anstatt für viele Kategorien jedes einzelne Symbol (und jede Symbolebene) oder viele regelbasierte Labels zu ändern.

Das Aussehen einer Karte in QGIS zu ändern, kann viel Arbeit bedeuten: Farbe und Liniendicke zahlreicher Symbole – die oft aus mehreren Symbolebenen bestehen – und die Schriftart / -größe verschiedener regelbasierter Beschriftungen müssen geändert werden, und jeder Schritt erfordert eine Menge Mausklicks. Vielleicht sähe es besser aus, wenn alle Straßen etwas breiter wären? Die Schriftgröße der Beschriftungen ein wenig größer? Wie wäre es, eine Schriftart, die in vielen Beschriftungsregeln verwendet wird, durch eine andere zu ersetzen? Oder eine einfarbig blaue Karte in eine pinke Karte zu verwandeln?

Ich habe ein Python-Plugin geschrieben, um all dies schnell und konsistent mit ein paar Klicks zu erledigen:

- Farbe aller Symbole (einschließlich Farbverläufe und einer beliebigen Anzahl von Symbolebenen) und Beschriftungen mithilfe des HSV-Farbmodells (hue, saturation, value) ändern (Farbton bzw. Farbkreis drehen, Sättigung und Helligkeit ändern)

- Liniendicken aller Symbole ändern (incl. Polygonränder)

- Schriftgröße aller Beschriftungen ändern

- Eine in Beschriftungen verwendete Schriftart überall durch eine andere Schriftart ersetzen

- Stile aller Ebenen in einen Ordner speichern bzw. aus einem Ordner laden.

- … und all das für alle Ebenen, für alle gewählten Ebenen oder für die aktive Ebene.

Installieren

Das Plugin ist im QGIS Plugins Repository und kann direkt von QGIS installiert werden (Menü: Erweiterungen > Erweiterungen verwalten und installieren).

Alternativ den Ordner mit dem Source Code in den Plugin-Ordner von QGIS kopieren (oder mit Git klonen) und das Plugin in QGIS aktivieren (Menü: Erweiterungen > Erweiterungen verwalten und installieren).

Verwendung

Das Plugin vom Menü oder dem Toolbar starten, auf der rechten Seite des Hauptfensters öffnet sich ein Werkzeugkasten. Als Erstes die Ebenen wählen, die angepasst werden sollen. Mögliche Auswahl:

- Aktive Ebene

- Gewählte Ebenen

- Sichtbare Ebenen

- Alle Ebenen

Farbe ändern

Das Anpassen von Farben funktioniert im HSV-Farbmodell. Das bedeutet, dass der Farbton der HSV-Farben wie ein Farbrad gedreht werden kann: Einfach den Winkel der Drehung einstellen und auf „OK“ klicken. Das Farbgitter oberhalb des Schiebereglers dient als Vorschau.

Um Sättigung und Farbwert (= Helligkeit) einzustellen, klicken Sie auf die entsprechenden Plus- und Minus-Buttons. Vorsichtig: Die Plus- und Minus-Schaltflächen können nicht verwendet werden, um bereits vorgenommene Änderungen rückgängig zu machen, da die Werte der Sättigung und des HSV-Werts im Intervall von 0 bis 255 bleiben und jede Farbe, die an diesen Grenzen ankommt, nicht im gleichen Maß zurückgeschoben werden kann. Es empfiehlt sich, die Ebenenstile zu speichern, bevor Sie diese Schaltflächen verwenden!

Liniendicke

Die Liniendicke aller Symbole (Linien und Ränder von Polygonen und Punktmarkern) wird bei Klicks auf die Plus-/Minusbuttons um ± 5 % geändert.

Beschriftungen

Hinweis: Die Änderung der Farbe einer Ebene ändert auch die Farbe der Beschriftungen (Text, Puffer, Hintergrund).

Schriftgröße: Die Plus-/Minusbuttons ändern die Schriftgröße überall um ± 5 %.

Schrift ersetzen: Eine im Projekt verwendete Schriftart überall durch eine beliebige Schriftart ersetzen.

Stile speichern und laden

Diese Schaltflächen bieten eine schnelle Möglichkeit, die Stile aller (oder aller ausgewählten) Ebenen zu speichern. Sie müssen nur einen Ordner auswählen. Der Dateiname der QML-Dateien entspricht dem Namen der Ebenen (wobei problematische Sonderzeichen durch Unterstriche ersetzt werden). Wenn es mehrere Ebenen mit demselben Namen gibt, werden dem Dateinamen zur Unterscheidung Indexwerte angehängt.

Wenn die Ebenennamen zweier Projekte übereinstimmen, ist es sogar möglich, die Stile eines Projektes für alle Ebenen direkt im anderen zu laden.

Die 2. Auflage von Bewegte Bergwelt

Mein Buch über Gebirgsbildung habe ich vollständig überarbeitet, aktualisiert und deutlich erweitert.

Seit Erscheinen der 1. Auflage meines Buchs Bewegte Bergwelt sind bereits mehr als zehn Jahre vergangen. Seither hat sich meine Vorstellung, was ein gutes Buch und gute Didaktik ausmacht, deutlich gewandelt. Auch die Geologie hat sich weiterentwickelt; es gibt neue seismische Profile, neue Datierungen und viele weitere interessante Studien und Diskussionen. Gute Gründe, um das Buch für die Neuauflage gründlich zu überarbeiten. Der Text ist wieder auf dem neuesten Forschungsstand und ich lege nun mehr Wert darauf, bei kontroversen Theorien beide Seiten der Diskussionen darzustellen. Nebenbei habe ich natürlich auch Fehler gefunden und verbessert. Ich habe zudem einige beliebte Reiseziele neu ins Buch aufgenommen, wodurch es auf einen Umfang von über 500 Seiten angewachsen ist.

Bewegte Bergwelt: Gebirge und wie sie entstehen

2. Auflage, vollständig überarbeitet

Springer, Oktober 2022

Gebunden: ISBN 978-3-662-64837-7

Ebooks: PDF, Kindle

Die wichtigste Zielgruppe sind weiterhin alle, die gerne in den Bergen sind, etwa zum Wandern, Bergsteigen oder Klettern. Das Buch ist aber auch für Studierende der Geografie und der Geowissenschaften geeignet, insbesondere bei der Reisevorbereitung und für einen Blick über den Tellerrand der eigenen Fachrichtung. Spannender als jede Bestandsaufnahme von Gesteinsformationen finde ich, wenn man sich die Vorgänge, die zur Entstehung eines Gebirges beigetragen haben, bildlich vorstellen kann. Die Prozesse, die Berge entstehen lassen und in Form bringen, sind ebenso faszinierend wie die resultierenden Landschaften. Das Buch lädt auf leicht verständliche Weise zu einer geologischen Weltreise ein und fördert dabei auch so manche Überraschung zutage.

Die 2. Auflage ist Anfang Oktober bei Springer erschienen und ist im Buchhandel erhältlich. Ebooks (PDF oder Kindle) gibt es bei diversen Online-Buchhändlern oder bei Springer Link. Das Titelbild zeigt übrigens Mount Everest und Nuptse, aufgenommen bei Sonnenuntergang vom Khalar Patthar.

Das Buch wurde bei dieser Gelegenheit auch ins Englische übersetzt: The Formation of Mountains erscheint im November, ebenfalls bei Springer. Das Titelbild zeigt Fitz Roy von der Laguna de los Tres.

The Formation of Mountains

November 2022, Springer

Hardcover: ISBN 978-3031113840

QGIS: Haupt- und Nebengipfel kategorisieren

In OpenStreetMap sehen alle Gipfel gleich aus. Wie kann man sie in QGIS als Haupt- und Nebengipfel klassifizieren?

Haben Sie schon einmal versucht, mit OpenStreetMap-Daten topografische Outdoor-Karten zu zeichnen? Wahrscheinlich ist Ihnen aufgefallen, dass in OpenStreetMap alle Gipfel gleich aussehen, sowohl Haupt- als auch Nebengipfel. Auf OpenStreetMap ist es fast unmöglich, den Hauptgipfel eines Bergmassivs zu finden! Mein QGIS-Plugin Nearest with greater value bietet eine einfache Möglichkeit zur Klassifizierung von Gipfeln, um Haupt- und Nebengipfel unterschiedlich zu zeichnen.

In meinem Beispiel habe ich zunächst alle Gipfel (in OpenStreetMap-Daten: Tag „natural=peak“) in eine separate Ebene extrahiert. Dann habe ich das Plugin nearest with greater value mit ele als „field to compare“ verwendet. Für die Darstellung der Ausgabeebene habe ich eine regelbasierte Symbolisierung verwendet:

"neargtdist">10000für dominante Gipfel (der nächst höhere Gipfel ist >10 km entfernt).("neargtdist" > 1000) AND ( "neargtdist" <=10000) AND ("name" IS NOT NULL)für Hauptgipfel (der nächst höhere Gipfel ist >1 km entfernt)ELSEfür Nebengipfel (schwarze Ringe in der Abbildung).

Ich habe in der Regel für Hauptgipfel "name" IS NOT NULL hinzugefügt. Der Grund sind einige kleinere Hügel in weiten Tälern, die sonst als Hauptgipfel eingestuft werden.

In QGIS einem Projekt mit einem Klick die richtige UTM-Zone zuweisen

Wer regelmäßig in QGIS einen GPS-Track öffnet oder an einer lokalen Karte arbeitet, möchte die Karte häufig im UTM-System angezeigt haben. Dazu musste man erstmal die korrekte UTM-Zone herausfinden und diese im entsprechenden Dialogfenster suchen. Mein erstes Plugin, das ich für QGIS geschrieben habe, erledigt das mit einem Klick auf den UTM-Schaltknopf (im Plugin-Toolbar). Es heißt ProjectUTM und ist bereits im QGIS Python Plugins Repository.

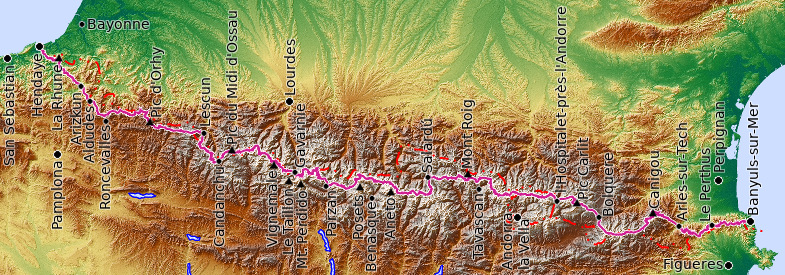

Pyrenäen-Traverse auf dem HRP

Wanderung vom Atlantik bis zum Mittelmeer: Trekking längs über die Pyrenäen auf der Haute randonnée pyrénéenne (HPR)

Längs über die gesamten Pyrenäen von einem Meer zum anderen wandern: Das ist so grandios, wie es klingt. Es geht durch ein wunderschönes Hochgebirge mit hohen Felswänden, ein paar kleinen Gletschern und dazu Tausenden Bergseen. Und im Gegensatz zu den Alpen ist die Landschaft nicht mit Bergbahnen, Skipisten und Hotels zugebaut.

Dabei hat man sogar die Auswahl zwischen drei Fernwanderwegen. Die meisten nehmen den französischen GR10 (neben dem GR20 auf Korsika einer der bekanntesten Treks in Frankreich). Ungefähr parallel verläuft auf der anderen Seite der Grenze der spanische GR11. Dazwischen (bzw. manchmal einem der GRs folgend) führt die deutlich anstrengendere Haute randonnée pyrénéenne (HRP) in ca. 40 Tagen wechselnd durch Frankreich, Spanien und Andorra; immer am Hauptkamm des Gebirges. Anders als die GRs ist der HPR aber nicht durchgehend markiert. Häufig geht es über unmarkierte Wege (und man muss herausfinden, welches der richtige Abzweig ist), manchmal auch einfach querfeldein, über steile Wiesen oder Blockhalden. Also nur etwas für geübte Trekker mit gutem Orientierungssinn, die sich sicher in alpinem Gelände bewegen können. Für diese ist der HRP ein wunderschön wilder und vergleichsweise einsamer Trek, den ich zu den schönsten in Europa zählen würde. Ein paar Gipfel wie Vignemale und Pico de Aneto kann man ohne großen Aufwand mitnehmen (wenn man Steigeisen dabei hat).

Etappen im Detail

Ich teile meinen Bericht in 5 Segmente, die jeweils etwas mehr als eine Woche lang sind:

HRP Teil 1: Vom Strand zu den Bergen

Zwischen Hendaye und Lescun führt der HRP über grüne Hügel und schließlich durch eine skurrile Karstlandschaft.

HRP Teil 2: Durch den Pyrenäen-Nationalpark

Auf dem HRP von Lescun nach Parzán mit Vignemale, Gavarnie und Pic du Midi d’Osseau.

HRP Teil 3: Über hohe Pässe

Zwischen Parzán und Salardú befinden sich die höchsten Berge der Pyrenäen und die höchsten Pässe des HRP.

HRP Teil 4: Auf einsamen Pfaden nach Andorra

Von Salardú nach L’Hospitalet-pres-I’Andorre führt der HRP durch die hinterste Ecke von Katalonien und durch Andorra.

HRP Teil 5: Die letzten Berge vor dem Mittelmeer

Zwischen L’Hospitalet-pres-I’Andorre und Banyuls-sur-Mer führt der HRP über Pic Carlit und Canigou und dann über zahlreiche Hügel zum Mittelmeer.

Ausrüstung

Ich hatte alles Gepäck (außer Isomatte) inklusive Zelt, Kocher und Essen für bis zu 7 Tage in einem 60-Liter-Rucksack. Ein Zelt ist unbedingt empfehlenswert, ohne müsste man einige Umwege machen. Außerdem sind die Biwakplätze zum Teil sehr schön. In Frankreich ist zelten grundsätzlich erlaubt, wenn es nicht explizit verboten ist. Im Pyrenäen-Nationalpark darf man (mit Zelt) zwischen 19 und 9 Uhr biwakieren (mindestens 1 h von Straßen entfernt). In Spanien und Andorra wird das Biwakieren oben in den Bergen in der Regel geduldet.

Ich hatte den Führer von Tom Martens, The Pyrenean Haute Route (Cicerone). Ich habe mich aber etwas über dieses Buch geärgert. Allein schon das Gewicht: 390 g. Wie kann man nur auf die Idee kommen, einen Wanderführer mit Marginalien zu drucken? Ohne das viele weiße Papier und in etwas kleinerem Format hätte man locker 100 g sparen können. Ein paar dumme Fehler enthält er auch.

Außerdem hatte ich den sehr knappen, aber guten HRP Pocket Guide von Whiteburn’s Wandering auf dem Handy.

Als Karte hatte ich nur Maps.me mit importiertem GPS-Track (siehe Pocket Guide) auf dem Handy, was an manchen Tagen sehr hilfreich war.

Verpflegung kann man alle paar Tage kaufen. Maximal muss man Essen für 7 Tage tragen, es ist in diesen Abschnitten aber auch möglich, unterwegs zu einem Ort abzusteigen. Oft sind das kleine Läden, manche mit guter Auswahl, andere nicht. Hin und wieder trifft man auf der spanischen Seite auf größere Supermärkte, die aber vor allem darauf spezialisiert sind, Schnaps und Schokolade an französische Schnäppchenjäger zu verkaufen. Die Auswahl an Proviant für Wanderer ist in den kleinen Läden eher besser. Manche der kleinen Läden verkaufen Gaskartuschen (Schraubkartuschen und Campinggaz): Col Bargargui, (Lescun gab es nur Campinggaz), Candanchu, Gavarnie, Bolquere.

Wasser ist vor allem am Anfang und am Ende problematisch, man muss hin und wieder mehrere Liter Wasser laden. Im zentralen Bereich kann man dafür häufig nachfüllen. Ich hatte ein 3-l-Trinksystem plus eine 1-l-Flasche; außerdem Micropur-Tabletten.